-

Checking Gradient Descent for convergence (경사하강의 수렴) | Supervised Machine Learning: Regression and ClassificationMachine Learning/Stanford ML Specialization 2023. 10. 30. 23:09

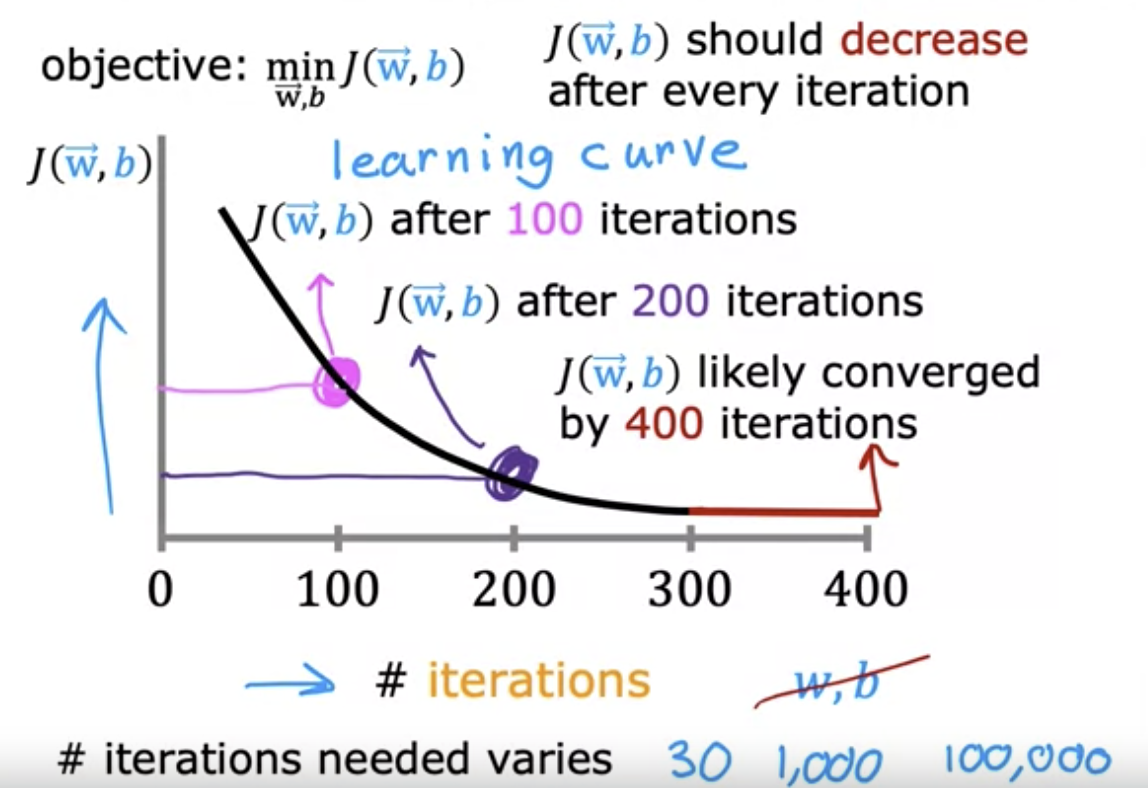

우리가 Gradient Descent을 계산할 때, 우리의 목적은 minimum값으로 수렴할 수 있도록 유도하고, 끝내 Minimum값을 찾아내는 것이다. 여기서 이 J값과 Iteration한 횟수를 그래프로 나타낸것을 Learning Curve라고 한다.

https://youtu.be/5g4H5_gsTpU 위 그래프에서 보면, 300번정도 Iteration을 했을 때, Minimum값에 가까워졌고, 300번과 400번의 차이가 얼마 없으므로, 400번때에는 Converged, 즉 수렴하고 있다고 판단할 수 있다. 참고적으로 어플리케션에 따라 어떤 모델은 30번만에 수렴을 하기도 하지만, 어떤 모델은 100,000번의 iteration이 필요할 수 있다. 이렇게 수렴한다고 평가하고, 최종 모델을 선정할 수 있다.

또다른 방법은 "epsillon"값을 정하고, 만약 J값이 "epsilon"보다 작아지게 되었을 때, Convergence(수렴)라고 선언을 하고, 그에 해당하는 w(벡터), b값을 이용한 모델을 선정할 수 있다.

Reference

'Machine Learning > Stanford ML Specialization' 카테고리의 다른 글